(źródło: Policy Note 1/2020)

Zdaniem

opozycyjnych wobec rządu komentatorów najnowszej edycji międzynarodowego

badania TIMSS - Wyniki polskich czwartoklasistów z matematyki w ciągu

czterech lat znacząco się pogorszyły. Wyniki uczniów najlepszych nie zmieniły

się, spadły natomiast osiągnięcia uczniów na średnim i niskim poziomie.

Eksperci

Evidence Institut, który założył były wiceminister edukacji za rządów PO/PSL

Maciej Jakubowski, słusznie twierdzą, że skoro polscy uczniowie

brali udział w tych diagnozach dopiero od 2011 roku, kiedy to w pierwszej

edycji TIMSS w Polsce badani byli uczniowie trzecich klas, to opublikowane w

2020 r. wyniki pomiaru z 2019 r. nie są porównywalne w czasie.

Niestety, nie dodali, że żadne wyniki badań poprzecznych nie są porównywalne w wymiarze temporalnym, gdyż nie są to badania podłużne (longitudinalne), a więc prowadzone na tej samej próbie uczniowskiej. Nie wolno zatem mówić, że w ciągu czterech czy więcej lat coś uległo poprawie i/lub pogorszeniu, bo nie dotyczy to tych samych uczniów, z tych samych szkół.

Udział w badaniu nie jest łatwy, bowiem uczniowie musieli rozwiązać zadania z obu dziedzin wiedzy w ustalonym czasie. Organizatorzy mieli do dyspozycji 350 zadań.

Skoro w 2011 i 2015 r. badaniami TIMSS byli objęci w Polsce uczniowie klas trzecich szkół podstawowych, to tym bardziej przeprowadzenie pomiaru w 2019 r. w grupie czwartoklasistów rodzi pytanie, czy aby nie był to celowy manewr władz resortu edukacji, by ewentualną porażkę zrzucić na poprzednią władzę?

Zdaniem A. Zalewskiej badani uczniowie klas czwartych sa w tym pomiarze ofiarami polityki PO-PSL. To jest argument demagogiczny, gdyż to nie podręcznik szkolny decyduje o wykształceniu, ale w pierwszej kolejności środowisko rodzinne uczniów, a w dalszej - nauczyciele realizujący podstawę programową oraz ich uczniowie z określonym poziomem wieku rozwojowego i aspiracji. O curriculum dla klas I-III nie można powiedzieć, że było infantylne w swej treści. Podręczniki same w sobie niewiele znaczą.

Porażka częściowo jest ewidentna w odniesieniu do tej próbki badanych, skoro najwyższym wynikiem może pochwalić się jedynie 8 proc. dzieci, zaś aż 7 proc. uczniów nie osiągnęło nawet najniższego poziomu wiedzy i umiejętności z matematyki, jakiej wymaga się na świecie od dziesięciolatków!

Pamiętajmy jednak, że pomiar objął tylko 4 882 uczniów klas czwartych z 149 wylosowanych szkół podstawowych. Jednak tak z matematyki, jak i przyrody nasi uczniowie uzyskali wynik powyżej średniej na poziomie 500 pkt. Zadania oceniane były w skali czterostopniowej (poziom: niski, średni, wysoki i bardzo wysoki).

Po

czterech latach edukacji w stylistyce programowej Anny Zalewskiej nasi

uczniowie są półanalfabetami!, gdyż nie potrafią rozwiązać najprostszych zadań

rachunkowych i rozpoznać figur geometrycznych. Może potrafią odróżnić kij od

szczotki od kija bejsbolowego?

Podobnie częściowo źle jest z wiedzą przyrodniczą badanych dziesięciolatków, skoro aż 5 proc. objętych pomiarem TIMSS nie opanowało najprostszej wiedzy i umiejętności w zakresie przyrody,

zaś na najwyższym poziomie odliczyło się tylko 9 proc. dzieci.

(źródło: tamże)

Niezależnie od wszystkiego, czy tego chcemy, czy nie, czy urzędnicy MEiN będą manipulować interpretacją tych danych bardziej lub mniej, to poziom wiedzy i umiejętności czwartoklasistów jest żenujący. Ci przecież powinni wypaść lepiej niż gdyby mierzono ich wiedzę i umiejętności pod koniec klasy trzeciej.

Niepokojące

jest, że znacznie gorzej z matematyki i nauk przyrodniczych wypadły dziewczęta

w porównaniu ze swoimi koleżankami sprzed czterech lat (z matematyki spadek aż

o 18 pkt., zaś z przyrody o 16 pkt.).

(źródło: tamże)

Wprawdzie

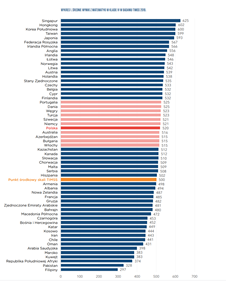

MEiN może się chwalić, że mimo wszystko i tak polscy uczniowie uzyskali wynik

wyższy od średniej w krajach OECD , która wynosi 500 pkt, a nasi mieli z matematyki

- 520 pkt., zaś z przyrody - 531 pkt.

Zobaczymy wkrótce, jak wypadną nasi piętnastolatkowie w badaniach PISA. Tu zapewne będzie jeszcze większy pogrom, biorąc pod uwagę skandaliczną dewastację ustrojową w polskim szkolnictwie, do której doprowadziła totalna ignorancja i populistyczna hucpa A. Zalewskiej.

Co z

nich wyrośnie, skoro była to tylko mała próbka, chociaż - w sensie

statystycznie uzasadnionego doboru - reprezentatywna?

Dorzucę Panu jeszcze jeden argument za nieporównywalnością badań z różnych lat, moim zdaniem istotniejszy, niż podłużność (zwłaszcza, jeśli badanie uznaje się za badanie systemów szkolnych, a nie konkretnych indywidualnych osób): TIMSS (tak samo jak PISA) prowadzi dość skomplikowaną procedurę normalizowania rozkładów tak, by w skali ogólnoświatowej wynik miał średnią 500 i odchylenie standardowe 100. Niby jest normalizowany do poziomu wyników z 1995, ale nie jest to możliwe, kalibracji nowych zadań dokonuje się na nowo dla każdej kolejnej edycji i inne, niż czysto arbitralne zgranie nowej kalibracji nowego ze starą kalibracją starego nie jest możliwe. Gdyby świat był jednolity, to musielibyśmy spodziewać się niezmiennych wyników dla poszczególnych krajów niezależnie od tego, czy cały świat równo by mądrzał czy głupiał. Świat jednak nie jest jednolity - spadek wyników uczniów w Polsce (również w Finlandii) może równie dobrze oznaczać, że dzieci w Brazylii zmądrzały. Albo może znaczyć jeszcze mniej: tylko tyle, że przyrost naturalny w krajach o niskim wyniku się obniżył, w skali światowej dominacja liczebna dzieci z Chin i ich wpływ na skalę punktową nad dziećmi z Europy się zmniejszyła. By było jeszcze trudniej, to najliczniejszy kraj (różny kulturowo od całej reszty) świata: Indie, nie uczestniczy w tym badaniu.

OdpowiedzUsuń"najwyższym wynikiem może pochwalić się jedynie 8 proc. dzieci, zaś aż 7 proc. uczniów nie osiągnęło nawet najniższego poziomu wiedzy"

To nie jest ani porażka, ani sukces, tylko prosta definicja, co nazywane jest najwyższym czy najniższym poziomem wiedzy. Jeśli coś ma rozkłąd normalny, to z samej istoty jego kształtu, część badanych osób/obiektów musi znaleźć się lewym lub prawym ogonie. A śladowa różnica (8% w prawym, 7% w lewym) wynika z tego, że rozkład dla Polski jest odrobinę przesunięty w stosunku do wyznaczającego kwantyle, którym przypisano nazwy, rozkładu wziętego dla całego świata.

Różnica pomiędzy trzecio- i czwartoklasistami. Nie ma tu żadnej rządowej manipulacji. Przynajmniej nie dzisiejszego rządu. TIMSS po prostu bada grupę wiekową 10-latków - to, czy to 3. czy 4. klasa jest skutkiem tego, czy kilka lat wcześniej do szkół szły 6- czy 7-latki, więc czy dziś większość 10-latków jest w 3. czy 4. klasie.

Wcale czwartoklasiści nie muszą wypadać lepiej! TIMSS pozwala poszczególnym krajom odrzucić ze swoich pytań te, które wykraczają poza krajowe curriculum dla większości dzieci o tym wieku. Gdy badało 10-latków, z których większość była w 3. klasie, to badało wyłącznie opanowanie przez nich polskiego curriculum trzech lat szkoły. Gdy bada grupę, z której większość jest w 4. klasie, to bada opanowanie przez nich bogatszego polskiego curriculum czterech lat. Selekcja zadań robiona jest dla każdego kraju oddzielnie - co swoją drogą czyni niemiarodajnym jakiekolwiek porównywanie wyników różnych krajów.

Nie rozumiem przyczyny, dla której zadania są selekcjonowane - wyraźnie TIMSS nie może zdecydować się, czy chce badać inteligencję i pracowitość pojedynczych uczniów w opanowaniu materiału, jaki już mieli w szkole, czy porównywać efekty, osiągane w różnych krajach przez ich systemy szkolne, godząc się, że jedne mogą mieć bogatsze curricula niż inne.

Oczywiście, możemy być pewni bicia piany i wzajemnego przerzucaia się urojoną winą przez PO i PiS oraz sympatyzujące z nimi media. Spadek (więc winny być musi) jest bezsporny (520 to mniej, niż 535 - nikt nie zaprzeczy, choć nikt nie umie zinterpretować takiej liczby i niemal nikt nie rozumie, jak nieistotna to różnica). Ale PiS może twierdzić, że to skutek zamieszaqnia z "sześciolatkami do szkół", a PO, że skutek zamieszania z wprowadzeniem przez PiS zmian w curriculum i zmiany 6-3-3 na 8-4.

Proszę nie nadinterpretować tego, że dziewczęta "spadły" bardziej, niż chłopcy. I tak mają trochę lepsze od nich wyniki. Poza tym różnica to spadek chłopców o 12p, a dziewcząt o 18p - czyli różnica między płciami to 6p - 0.06 odchylenia standardowego.

W badaniu 2011 brali uczniowie klas 3. W badaniu 2015 i 2019 - klas 4. Wie Pan pewnie, że w tym badaniu wiele zadań jest utajnionych. Uczniowie każdej edycji rozwiązują te same zadania. Dlatego można porównać w czasie wynik z 2015 i 2019. Nie porównywano - z powodu tego, że w badaniu 2011 brali udział uczniowie po 3 klasie - wyników z 2011 i 2015. A proszę napisać jak sobie Pan wyobraża badanie uczniów i wyników nauczania w czwartej klasie w jakimś dłuższym okresie czasu?

OdpowiedzUsuńPozdrawiam

Małgorzata Zambrowska

Uczniowie w badaniu TIMSS nie rozwiązują 350 zadań testowych. Może warto - zanim się napisze oburzony komentarz - dowiedzieć się jak wygląda badanie? Podzielę się wiedzą na ten temat.

OdpowiedzUsuńNiestety, nie podpisałbym się pod pańskim zdaniem a propos porównywalności w czasie wyników badań TIMSS:

OdpowiedzUsuń"Niestety, nie dodali, że żadne wyniki badań poprzecznych nie są porównywalne w wymiarze temporalnym, gdyż nie są to badania podłużne (longitudinalne), a więc prowadzone na tej samej próbie uczniowskiej. Nie wolno zatem mówić, że w ciągu czterech czy więcej lat coś uległo poprawie i/lub pogorszeniu, bo nie dotyczy to tych samych uczniów, z tych samych szkół."

Autorzy badań twierdzą bowiem:

"To make scores from the second (1999) wave of TIMSS data comparable to the first (1995) wave, two steps were necessary. First, the 1995 and 1999 data for countries and education systems that participated in both years were scaled together to estimate item parameters. Ability estimates for all students (those assessed in 1995 and those assessed in 1999) based on the new item parameters were then estimated. To put these jointly calibrated 1995 and 1999 scores on the 1995 metric, a linear transformation was applied such that the jointly calibrated 1995 scores have the same mean and standard deviation as the original 1995 scores. Such a transformation also preserves any differences in average scores between the 1995 and 1999 waves of assessment.

In order for scores resulting from subsequent waves of assessment (2003, 2007,2011, and 2015) to be made comparable to 1995 scores (and to each other), the two steps above are applied sequentially for each pair of adjacent waves of data: two adjacent years of data are jointly scaled, then resulting ability estimates are linearly transformed so that the mean and standard deviation of the prior year is preserved. As a result, the transformed-2015 scores are comparable to all previous waves of the assessment and longitudinal comparisons between all waves of data are meaningful.

To facilitate the joint calibration of scores from adjacent years of assessment, common test items are included in successive administrations. This also enables the comparison of item parameters (difficulty and discrimination) across administrations. If item parameters change dramatically across administrations, they are dropped from the current assessment so that scales can be more accurately linked across years. In this way even if the average ability levels of students in countries and education systems participating in TIMSS changes over time, the scales still can be linked across administrations.

Scaling for TIMSS Advanced follows a similar process, using data from the 1995, 2008, and 2015 administrations".

Poza tym, czyż nie jest znaczące, że "normalizowane" wyniki badań/testów TIMSS w kolejnych edycjach układają się dość "sensownie".

Z interpretacjami i analizą przyczyn stanu rzeczy byłbym ostrożny.

Na przykład skąd relatywnie wysokie wyniki testów dzieci w Rosji, a niskie we Francji no i ten Singapur - legenda ...?

Pani Zambrowska uważa, że mój komentarz jest nacechowany oburzeniem. Ciekawe, na podstawie czego tak sądzi?

OdpowiedzUsuńNie podzieliła się wiedzą na temat tego, ile zadań rozwiązywali w ramach badań TIMSS - 2019 czwartoklasiści. Ministerstwo też w tej sprawie nie przekazało informacji. Poczekamy na polski raport, to może dowiemy się.

Istotnie w 2015 r. w pomiarze TIMSS brali udział także czwartoklasiści, natomiast w 2011 trzecioklasiści. Nie wyjaśnia powodu, dla którego wiek badanych został przesunięty w stosunku do tego, jaki obowiązywał w 2011 r. Rozumiem, że jako podwładna MEiN nie bardzo jest pani zainteresowana wyjaśnieniem tych kwestii.

Rzeczywiście dzieci wypełniają zadania tylko w dwóch zeszytach z 16 kompletów. Tego nie dodałem, co wprowadzało w błąd czytelników. Żadne dziecko nie odpowiedziałoby na 350 pytań/zadań. Poprawiam zatem wpis w tym miejscu dziękując za uwagę.

Skoro twierdzi pani Zambrowska jako członek polskiego zespołu badawczego, że zadania są porównywalne w każdej edycji, to muszę w to uwierzyć. Jednak są one utajnione (nie podaje Pani w jakim zakresie - czy w 60%?), toteż w nauce wiara zdaje się mieć znaczący udział tylko w metodologii badań teologicznych. Być może tak jest. Ja w to wątpię, że od 1995 r. - kiedy to rozpoczęto pierwszą edycję TIMSSS nie zmieniano treści zadań. Aż tak naiwny nie jestem. W końcu to prawie ćwierć wieku.

Odczytuję w ostatnim komentarzu Pani oburzenie, że w ogóle ośmieliłem się zabrać głos w tej sprawie. Cytuję: "Oczywiście, możemy być pewni bicia piany i wzajemnego przerzucania się urojoną winą przez PO i PiS oraz sympatyzujące z nimi media."

Otóż mnie nie interesuje ani bicie piany, ani to, kto to czyni - zwolennicy PO czy afirmatorzy PiS.

Absolutnie nie ma Pani racji pisząc:

"Porzucę Panu jeszcze jeden argument za nieporównywalnością badań z różnych lat, moim zdaniem istotniejszy, niż podłużność (zwłaszcza, jeśli badanie uznaje się za badanie systemów szkolnych, a nie konkretnych indywidualnych osób)".

Żadne badania OECD nie są badaniami systemów szkolnych, bo gdyby tak było, to musiałaby to Pani nam udowodnić. Tymczasem jak poczytamy literaturę naukową na temat tego typu diagnoz, to dowiemy się, że nie mają one nic wspólnego z komparatystyką powyższego rodzaju. Pani jdnak nie musi o tym wiedzieć jako wykonawczyni zlecenia.

Co do porównywalności - raz jeszcze podkreślam, badania poprzeczne są tylko częściowo porównywalne, w bardzo ograniczonym zakresie. To oczywiste, ze tego typu jednorazowy pomiar nie może mieć nic wspólnego z badaniami podłużnymi. Co do tego nie musi mnie Pani przekonywać. Natomiast sposób formułowania także przez Panią wniosków na temat rzekomej porównywalności wyników tych badań jest nietrafny. W polemice sama Pani zaprzecza sobie.

- "Niby jest normalizowany do poziomu wyników z 1995, ale nie jest to możliwe, kalibracji nowych zadań dokonuje się na nowo dla każdej kolejnej edycji i inne, niż czysto arbitralne zgranie nowej kalibracji nowego ze starą kalibracją starego nie jest możliwe."

Ba, przyznaje Pani dalej: "Selekcja zadań robiona jest dla każdego kraju oddzielnie - co swoją drogą czyni niemiarodajnym jakiekolwiek porównywanie wyników różnych krajów."

A pisała Pani, że zadania są te same. To w końcu, jak jest? Pisze Pani: "Wcale czwartoklasiści nie muszą wypadać lepiej! TIMSS pozwala poszczególnym krajom odrzucić ze swoich pytań te, które wykraczają poza krajowe curriculum dla większości dzieci o tym wieku."

Ja też nie rozumiem: (...) przyczyny, dla której zadania są selekcjonowane - wyraźnie TIMSS nie może zdecydować się, czy chce badać inteligencję i pracowitość pojedynczych uczniów w opanowaniu materiału, jaki już mieli w szkole, czy porównywać efekty, osiągane w różnych krajach przez ich systemy szkolne, godząc się, że jedne mogą mieć bogatsze curricula niż inne."

OdpowiedzUsuńProszę zatem nie denerwować się moim wpisem. Nie dysponuję przekładem polskiej wersji raportu. Czesi już go mają , a MEiN trzyma w szafie czy zlecił Państwu ocenzurowanie?

Jak będzie pełna wersja , to zabiorę głos. Tymczasem dziękuję za wykazanie mojego błędu we wpisie dotyczącego liczby zadań. Już to usuwam.

Co ciekawe w 2015 r. było 14 zeszytów, a 2019 - już 16. To też jest dowód na to, że poprzeczna diagnoza jest porównywalna?

OdpowiedzUsuńDopiero teraz zapoznałem się z dokumentem ze strony MEN:

"Prezentacja wyników

Międzynarodowego Badania Wyników

Nauczania Matematyki i Nauk Przyrodniczych

z udziałem Podsekretarza Stanu w Ministerstwie

Edukacji Narodowej Macieja Kopcia"...

No takiego shitu dawno nie widziałem.

To pornografia prezentacji wyników - jakichkolwiek wyników badań, a badań wyników nauczania w szczególności. To szczyty niekompetencji i pitolenia w bambus...

https://www.gov.pl/web/edukacja/wyniki-badania-timss-2019